bu kullanıcılar için ne anlama geliyor?

Amerikan şirketi OpenAI, yapay zekaya (AI) dayalı ChatGPT sohbet robotunu kullanma politikasını güncelledi – bu teknolojinin askeri amaçlarla kullanılmasına ilişkin doğrudan yasak, belgeden kaldırıldı. Uzmanlara göre yapay zeka gelecekte askeri çatışmaları kökten değiştirebilir, ancak savaşta kullanılması çok sayıda riskle ilişkilidir. ChatGPT’nin askeri amaçlarla kullanılmasına neden izin verildiği ve bu kararın nelere yol açabileceği hakkında ayrıntılı bilgi için İzvestia makalesini okuyun.

Büyük değişiklikler

ChatGPT kullanım politikasındaki değişikliklere git algılanan Intercept tarafından yayınlandı. Gazetecilerinin yayınında belirtildiği gibi, 10 Ocak’a kadar OpenAI geliştirmelerinin kullanımına ilişkin kuralların yer aldığı sayfada, yapay zekanın “yüksek fiziksel zarar riski içeren faaliyetler” için kullanımını yasaklayan özel bir hüküm vardı; silah geliştirme” ve “askeri faaliyetler”.

Bunlar düzenlemeler, ChatGPT’nin Savunma Bakanlığı da dahil olmak üzere herhangi bir paramiliter devlet kurumu tarafından kullanılmasını yasaklıyordu. Ancak chatbot kullanımına ilişkin kuralların yeni versiyonunda, hem orduda hem de askeri işlerde kullanımının kabul edilemez olduğuna ilişkin madde kaldırıldı.. Aynı zamanda, silah üretimi veya kullanımı da dahil olmak üzere, OpenAI sinir ağlarının kendine veya başkalarına zarar vermek amacıyla kullanılması yasağı da devam etti.

OpenAI’nin açıkladığı gibi, kural ve ilkelerin basitleştirilmesi ihtiyacı nedeniyle ChatGPT politikası değiştirildi. Şirket, “kendinize veya başkalarına zarar vermeme” şartının hala çok geniş olduğunu belirtti. Ayrıca chatbot kullanılarak silah geliştirilmesi ve kullanılmasına ayrı bir yasak getirilerek bu durum açıklığa kavuşturuluyor.

OpenAI, “Ordu da dahil olmak üzere teknolojilerimizin silah geliştirmek veya kullanmak, başkalarına zarar vermek veya mülkleri yok etmek veya herhangi bir hizmet veya sistemin güvenliğini ihlal eden yetkisiz faaliyetlerde bulunmak amacıyla kullanılması yasaktır” diye vurguladı.

Pentagon’a doğru

Mirey Robotics’in kurucusu ve CEO’su olan yapay zeka uzmanı Andrei Natashkin, Izvestia ile yaptığı röportajda şunları belirtiyor: OpenAI’nin geliştirmelerinin askeri amaçlarla kullanılacağını açıkça ifade ettiği söylenemez. Sadece veri kullanım politikasını değiştirdi ve büyük olasılıkla buna gerçekten odaklanmak istemedi.

Uzman, “Askeri amaçlarla chatbot kullanımına yönelik doğrudan yasağın belgede yer almaması gazeteciler tarafından fark edildi ve ardından şirket temsilcileri yorum yapmak zorunda kaldı” diyor.

Natashkin’e göre bu pozisyon kesinlikle anlaşılabilir: Büyük BT şirketleri, orduyla temasları nedeniyle kendilerini birçok kez skandalların ortasında buldu. Örneğin 2017 yılında Savunma Bakanlığı ile işbirliği yapın Amerika Birleşik Devletleri Google Şirketi oldu – Makine öğrenimi alanındaki gelişmeler, insansız hava araçlarıyla hedeflerin daha isabetli şekilde vurulması ve yüz tanıma da dahil olmak üzere, Amerikan ordusunun çeşitli görevlerinde kullanılacaktı.

Andrei Natashkin, aynı zamanda Google’ın orduyla işbirliği yapma kararının hem şirket çalışanları arasında hem de dış ortamda güçlü bir olumsuz tepkiye neden olduğunu belirtiyor. Sonuç olarak, kamuoyunun baskısı altında, şirket açıkça işbirliği yapmayı reddetti ve politikası, yapay zeka gelişmelerinin askeri görevlerde kullanılmasının doğrudan yasaklanmasını içeriyordu.

Uzman, “2022’de başka bir büyük Amerikan şirketi Boston Dynamics, daha önce benzer bir durumla karşı karşıya olmasına rağmen gelişmelerini orduya aktarmayacağını duyurdu” dedi.

Gazinformservice entegre bilgi güvenliği sistemleri departmanı baş uzmanı Dmitry Ovchinnikov, aynı zamanda, Pentagon ve ABD hükümetinin en büyük müşteriler olması nedeniyle bu tür bir işbirliği olasılığının çeşitli şirketler için son derece cazip olduğunu söylüyor. Uzmana göre, Boeing Corporation ve Silikon Vadisindeki birçok şirket askeri siparişlerle büyüdü. Ve Apple, yenilikçi ürünlerinin çoğunu, ABD ordusunun çıkarları doğrultusunda ABD hükümetinin bağışları ve yatırımları temelinde geliştirilen teknolojilere dayanarak yaratıyor.

Savaş umutları

Mali bileşen, Pentagon ile bir sözleşme imzalamanın birçok şirketin yönetimi için değerli bir hayal olmasının nedenidir, diyor Dmitry Ovchinnikov. Ancak başka bir neden daha var: ChatGPT de dahil olmak üzere chatbotların kullanımı üzerinde tam kontrolün imkansızlığı.

İzvestia’nın muhatabı, “Evet, çok sayıda kısıtlama oluşturabilir ve kullanıcıları bir lisans sözleşmesi imzalamaya zorlayabilirsiniz, ancak aslında ChatGPT, yaratıcıların bilgisi olmadan askeri amaçlarla kullanılabilir” diye açıklıyor. – Peki neden kontrol edilemeyecek bir kısıtlama getirilsin?

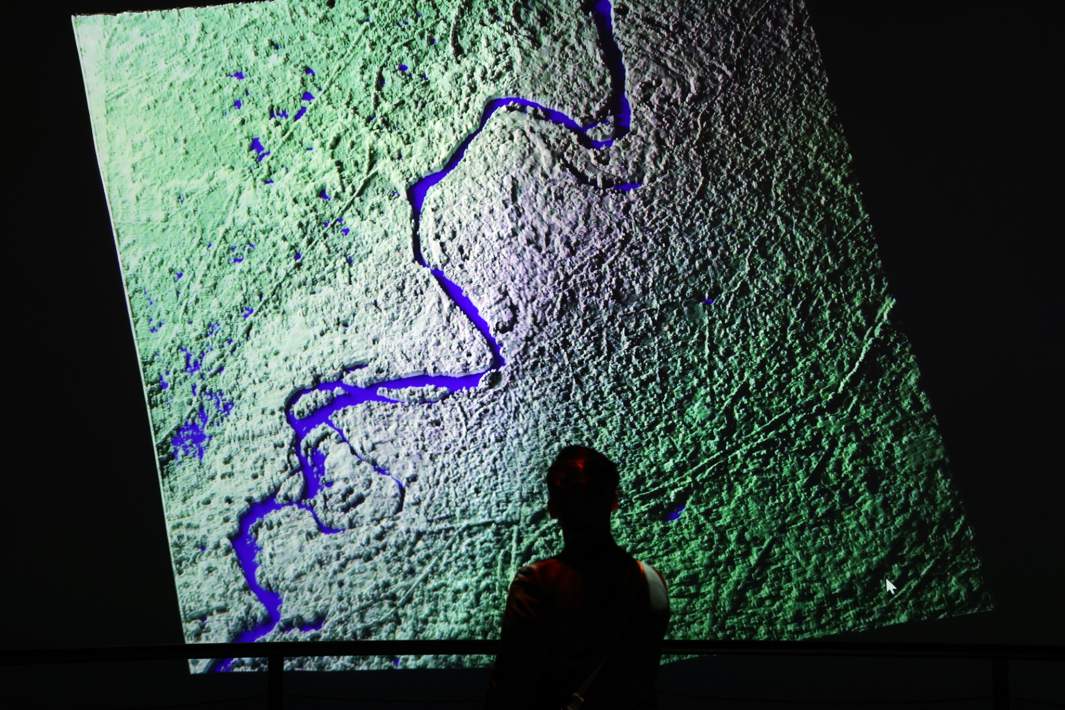

Ovchinnikov’a göre sinir ağları ve yapay zeka halihazırda ordu tarafından uydu fotoğrafı işleme algoritmalarında aktif olarak kullanılıyor. Ayrıca, Balistik ve gemisavar füzelerin pek çok yönlendirme başlığı ilkel yapay zeka ile donatılmıştır. Bu arada Andrei Natashkin şunu belirtiyor: Yapay zekanın askeri amaçlarla kullanılması potansiyel olarak büyük riskler taşıyor.

Uzman, “Her şeyden önce, teknolojinin kontrolü ve bedeli insan hayatı olan hataların sorumluluğu sorunu ortaya çıkıyor” diyor. “Ve bugün de benzer vakalar var.”

Örnek olarak Natashkin, 2020 yılında Libya’da meydana gelen ve bir savaş drone’unun otomatik olarak bir hedefi takip edip saldırdığı bir olayı aktarıyor. Resmi olarak, bu olayla ilgili tüm bilgiler gizli tutuldu – parçalı veriler yalnızca bir yıl sonra yayınlanan BM Güvenlik Konseyi raporunda yer alıyor. Bu belgeden saldırının Libya’da gerçekleştiği, dronun Türkiye’de üretildiği ve “insan hedefinin” vurulduğu biliniyor. Bu vaka, yapay zekanın insan kontrolü olmadan saldırmasının ilk gerçek örneğiydi.

Dmitry Ovchinnikov, gelecekte yapay zekanın askeri alanda kullanımının yalnızca artacağına inanıyor. Örneğin, Bir füze sürüsü, hedefleri daha güvenilir bir şekilde vuracağı ve düşmanın füze savunmasını (BMD) bastıracağı için genel yapay zeka ile donatılabilir.

arka taraf

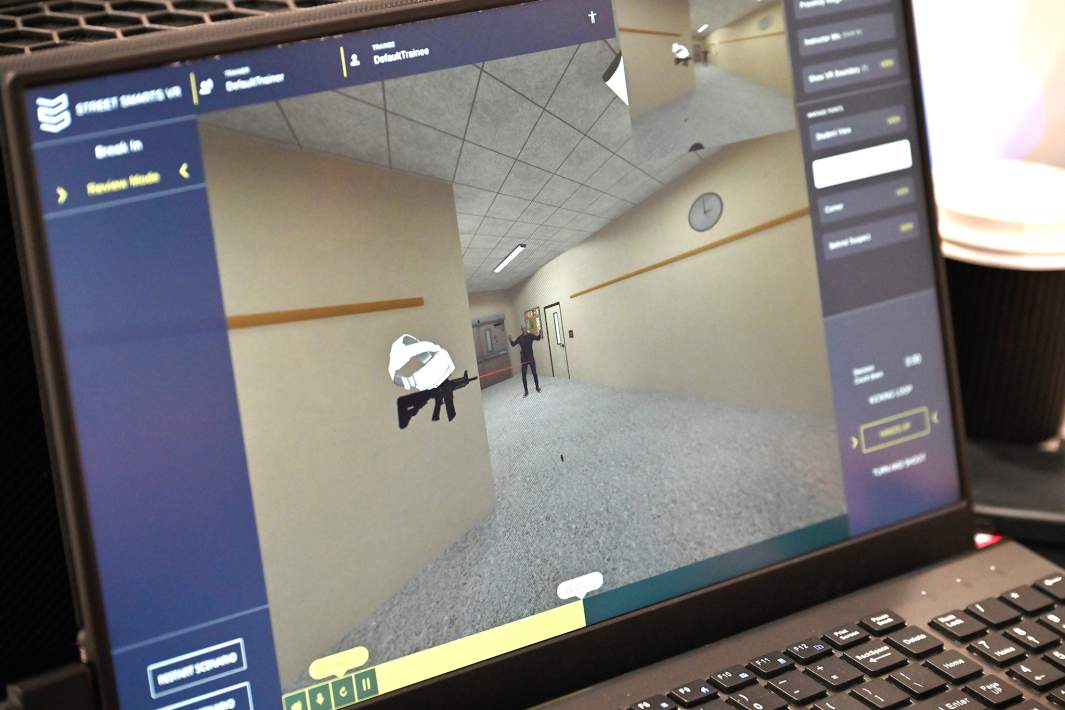

Bu arada, Güvenlik Kodu şirketinin ticari direktörü Fedor Dbar, yapay zekanın askeri alanda kullanılmasına ilişkin olasılıklardan bahsederken, sinir ağları ve ChatGPT gibi teknolojiler kavramlarını ayırma çağrısında bulunuyor. Sinir ağları askeri işlerde uzun süredir ve aktif olarak kullanılmaktadır: bunlar yüksek hassasiyetli silahlara yönelik yönlendirme sistemleridir ve geniş bant iletişim formatı, şifreleme ve çeşitli savaş kontrol sistemleri veya dronlarla çalışır.

İzvestia’nın muhatabı, “Aynı zamanda, ChatGPT gibi teknolojilerin, herhangi bir askeri görevde pek işe yaramayan sinir ağlarının kullanımının “sivil” bir versiyonu olduğunu anlamak da önemli” diyor. – Genel olarak Chatbotların askeri amaçlı kullanımına yönelik tüm tehditler fazlasıyla abartılıyor.

Dbar’a göre yapay zeka veya sinir ağlarının günümüzde insanlığa tehdit oluşturabileceği yönündeki konuşmalar amatörlük kategorisine giriyor. Şu anda dijital teknolojiler gezegeni tehdit etmiyor. Uzmanın açıkladığı gibi, tüm yapay zeka tabanlı araçlar, diğer şeylerin yanı sıra, geliştirme süreci sırasında ürünlerine güvenlik mekanizmalarını da dahil eden programcılar tarafından yaratılıyor.

Uzman, “İnsanlığa yönelik tehditler açısından bakıldığında, nükleer bir savaş veya Dünya’ya bir asteroitin düşme olasılığı çok daha tehlikeli görünüyor” diye vurguluyor.

Fedor Dbar, günümüzde ne özel bir yapay zekanın ne de herhangi bir sistemi tamamen kontrol edebilecek bir sinir ağının mevcut olmadığını ekliyor. Elbette satrançta bir bilgisayar taşları hareket ettirebilir ve strateji yoluyla düşünebilir, ancak gerçekte (özellikle askeri alanda) şu anda durum böyle değil ve böyle bir teknolojinin öngörülebilir gelecekte ortaya çıkması pek olası değil. Bu nedenle, uzman, sinir ağlarının (yani sohbet robotları değil, sinir ağlarının) yalnızca bazı askeri altyapıların bir unsuru olabileceği, ancak tam teşekküllü “komutanların” olamayacağı sonucuna varıyor.